Le prospettive che si aprono grazie all’intelligenza artificiale sono enormi. Secondo Bill Gates, sono in grado di cambiare il mondo quanto l’introduzione dei microprocessori, o la diffusione di Internet. Inevitabilmente per gli investitori si sta trasformando in una corsa all’oro.

L’Europa vorrebbe proporsi come sede di sviluppo, invocando la nascita di un “CERN” per la AI.

In parallelo si sviluppa un dilemma etico, dalle parole di Sam Altman, fondatore di openAI (la società che ha realizzato chatGPT):

"La nostra missione è garantire che l'intelligenza artificiale generale - i sistemi di intelligenza artificiale che sono generalmente più intelligenti degli esseri umani - sia di beneficio per tutta l'umanità".

E’ evidente che dei rischi potenziali di questa tecnologia è necessario discutere e valutare cosa occorre limitare, finché è possibile farlo.

Qui, per chi volesse, un paper sui “pappagalli stocastici” (brillante definizione della AI) e sull’impatto che possono avere sul contesto in cui viviamo. Abbiamo bisogno di una normativa che imponga la trasparenza. Non solo dovrebbe essere sempre chiaro quando ci troviamo di fronte a media sintetici, ma le organizzazioni che costruiscono questi sistemi dovrebbero anche essere tenute a documentare e divulgare i dati di formazione e le architetture dei modelli.

Uscite come quella del Center for AI Safety:

"Mitigare il rischio di estinzione del genere umano da parte dell'AI dovrebbe essere una priorità globale insieme ad altri rischi su scala sociale come le pandemie e la guerra nucleare".

Genera, per me, un problema con la parola "estinzione". Puoi credere o meno che l'attuale traiettoria dei sistemi di AI ponga un rischio di estinzione, ma più si usa questo termine, più è probabile che diventi questione di sicurezza nazionale. La cui priorità è sconfiggere gli avversari stranieri: quindi più si dice che i sistemi di AI possono essere superpotenti, più i consiglieri per la sicurezza nazionale insisteranno sul fatto che è necessario disporre della tecnologia superiore. Di conseguenza questo è il modo per accelerare la ricerca sull'AI, non per rallentarla.

L'onere di creare strumenti sicuri da usare (e di rispondere degli output di questi prodotti) dovrebbe ricadere sulle aziende che costruiscono e distribuiscono i sistemi generativi. Per quanto possa fare speculazioni intellettuali sui temi etici, a me spetta un altro lato del lavoro. Sono un investitore e devo concentrarmi sugli aspetti economico-finanziari.

Ho quindi dedicato alcune giornate a approfondire, studiare, comprendere la vasta tematica dell’AI. Sono partito ascoltando interessanti considerazioni sull’atteso aumento di produttività, e ne ho tratto alcune opinioni. Ve li espongo con ordine:

I processori su cui cresce la AI

La società più citata e che ha finora ottenuto le performance più strabilianti è Nvidia, l’azienda che all’inizio degli anni 2000 era conosciuta per le schede grafiche super-performanti è cresciuta enormemente, arrivando a capitalizzare oltre mille miliardi di $ sul listino USA.

Ci sono diverse ragioni per questo: i processori “grafici” (GPU - Graphical Processor Unit) prodotti da Nvidia si sono rivelati particolarmente adatti a elaborare lo sviluppo dell’AI, grazie alla loro struttura che prevede lo sviluppo in parallelo di molteplici processi. Molto meglio delle tradizionali CPU che risolvono task linearmente (cioè uno dopo l’altro)

Nel 2007 NVIDIA ha poi introdotto la prima versione di CUDA (Compute Unified Device Architecture), uno strumento di programmazione cruciale per lo sviluppo del machine learning perché ha permesso di modificare facilmente le istruzioni a livello hardware delle GPU: è importante capire che l'hardware non comprende i linguaggi di programmazione, vengono utilizzati programmi intermedi (detti interpreti, o compilatori) per tradurre i linguaggi fino a farli diventare codice macchina leggibile dall'hardware. Questo processo produce una grande dispersione di energia.

Queste inefficienze sono state eliminate quando si è iniziato a sviluppare l'apprendimento automatico (che Nvidia ha distribuito già nel 2014), nonché hardware specializzato, come le TPU (Tensor Processing Unit) di Google, che sono state presentate al pubblico nel 2016.

Soppiantare Nvidia, insomma, sembra una sfida molto complessa, perché non si tratta semplicemente di hardware, ma di un intero ambiente integrato con piattaforma di programmazione e elementi tecnici non intercambiabili.

Tuttavia l’arrivo del quantum computing potrebbe stravolgere il panorama: gli attuali microchip verrebbero abbandonati.

I fornitori dei processori

Ma per funzionare a dovere, le GPU di Nvidia hanno bisogno di supporto: è necessario che le informazioni vengano immesse nel computer rapidamente e senza ritardi. È qui che entrano in gioco i chip di memoria.

I processori non leggono i dati direttamente da un disco rigido: sarebbe troppo lento e inefficiente. I dati devono stare in una memoria temporanea: la DRAM (Direct Random Access Memory).

Quando si elaborano miliardi di informazioni in una singola operazione, è necessario che i dati siano a portata di mano e che vengano forniti rapidamente. La mancanza di una DRAM adeguata in un sistema rallenterà notevolmente un computer, rendendo inutile spendere migliaia di euro per i migliori processori.

Per ogni processore AI di fascia alta, occorre una quantità di DRAM, 30 volte superiore a quella di un laptop di fascia alta. Questa fame di memoria fa sì che la DRAM venduta per l'uso nei server sia destinata a superare quella installata negli smartphone già entro quest'anno, secondo alcune ricerche.

Ma non finisce qui: questi sistemi devono poi salvare grandi quantità di dati in modo da poterli leggere e scrivere rapidamente. E questo avviene su NAND Flash. Samsung è il leader mondiale in questo settore, seguita dalla giapponese Kioxia e da SK Hynix, queste tre aziende controllano il 95% del mercato delle DRAM.

I fornitori di wafer

Da molto tempo, ormai, l’insegnamento di Adam Smith sulla progressiva specializzazione di ogni attività è stato raccolto anche nel mondo dei chip: disegnare e produrre chip è un mestiere a difficoltà crescente e Morris Chang, il geniale fondatore di TSMC (Taiwan Semiconductor Manufacturing Company), un’azienda dedicata alla sola costruzione fisica dei chip, per permettere ai più noti “produttori” di diventare aziende di progettazione, di design di questi chip.

Il patto proposto da Chang è che TSMC non si occuperà mai di progettare chip, ma solo di fabbricarli, sollevando ogni altro produttore dalla paura della perdita di proprietà intellettuale.

Il progetto sembrava folle, si è rivelato un clamoroso successo: oggi oltre il 90% del mercato mondiale dei chip di altissima fascia è prodotto da TSMC a Taiwan. E qui cominciano i problemi: il mutato quadro geopolitico impone di tutelarsi dal rischio di dipendere dalle forniture di un solo Paese. Specialmente se questo paese è oggetto delle mire cinesi, con Pechino che considera Taiwan come territorio nazionale.

In uno scambio di sanzioni tra Occidente e Cina, capire a chi resterebbero i chip di Taiwan farebbe la differenza fra la vita e la morte, perché i chip sono essenziali al funzionamento dell’economia, ma anche a quello degli armamenti. Due esempi concreti di questo sviluppo degli eventi sono la perdita di mercato che ha subito Micron, bannata dal mercato cinese per motivi di sicurezza nazionale, e la scelta di Apple di un nuovo fornitore: Broadcom, esattamente perché statunitense e dunque al riparo da rischi geopolitici.

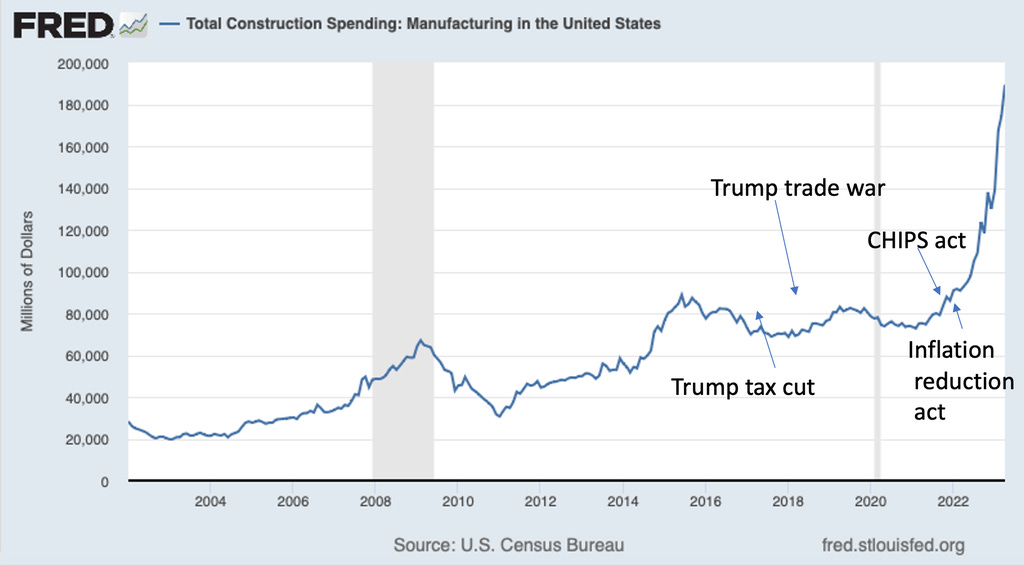

Gli Stati Uniti hanno così lanciato il Chips Act, un piano da 52 miliardi di $ per creare stabilimenti produttivi di chip in USA. Anche la UE ha lanciato un piano analogo per 43 miliardi di €, che fissa l'ambizioso obiettivo di produrre il 20% dei semiconduttori mondiali entro il 2030. Questi piani incoraggiano le imprese private a investire, mobilitando così ulteriori risorse nella stessa direzione: Intel, ad esempio, si sta attivando per ottenere la fetta più grande possibile di questi incentivi della Casa Bianca, ma in generale la ripartenza della spesa per costruire impianti manifatturieri sta funzionando. Molto più della politica di Trump, che diceva di voler riportare la manifattura in USA

La UE ha finanziato con 8 miliardi di € progetti di ricerca sui semiconduttori a questi si aggiungono 13,7 miliardi di € di finanziamenti privati, per un totale di circa 22 miliardi di €. Sono 68 gli IPCEI (Progetti Importanti di Interesse Comune Europeo) approvati.

Le aziende più attive su questi sussidi sono Intel, Infineon, STM, GlobalFoundries e Wolfspeed. Anche TSMC sta valutando la possibilità di costruire un sito produttivo in Germania.

"L'Europa sta prendendo in mano il proprio destino. Padroneggiando i semiconduttori più avanzati, l'UE diventerà una potenza industriale nei mercati del futuro"

I progetti dell'IPCEI costituiscono solo una componente del Chips Act europeo, sarà cruciale che questi progetti possano avere una burocrazia facilitata, i tempi di approvazione faranno la differenza in questa fase.

Dove andranno tutti questi soldi?

Questa è la domanda che l’investitore è indotto a porsi e la risposta è molteplice: serviranno molte cose per avere stabilimenti funzionanti. Innanzitutto servono macchinari capaci di realizzare chip di 3 o anche 2 nanometri. Che si realizzano con una tecnologia che si chiama EUV (Extreme Ultra Violet) e su cui l’azienda olandese ASML ha uno straordinario gap tecnologico verso la concorrenza.

Ma questo non consumerà tutto il capitale, perché attorno a quei macchinari serviranno ingegneri e personale qualificato. Persone che potrebbero andare a lavorare in Silicon Valley per qualche azienda di servizi che paga molto bene. Convincerli a dedicarsi alla produzione di chip implica la costruzione di asili e di una serie di facilities…

Cosa serve per fabbricare chip?

Nelle vicinanze di una fabbrica di chip servono grandi bacini d’acqua, e impianti di riciclo dell’acqua, in ragione dei rischi da cambiamento climatico. Vista l’impennata di nuove fabbriche, questo genere di impianti diverrà di ampia distribuzione.

Questo quadra con le parole di Mario Draghi al Mit Samberg Conference Center di Cambridge, dove è stato insignito del prestigioso Miriam Pozen Prize

“dobbiamo prepararci a un periodo prolungato in cui l’economia globale si comporterà in modo molto diverso rispetto al recente passato. Per esempio, mi aspetto che i governi abbiano deficit sempre più alti, perché le prossime sfide globali richiederanno investimenti pubblici sostanziosi che non possono essere finanziati solo da aumenti di tasse. Queste spese eserciteranno un’ulteriore pressione sull’inflazione, oltre ad altri possibili shock dal lato dell’offerta derivanti dall’energia e da altri beni"

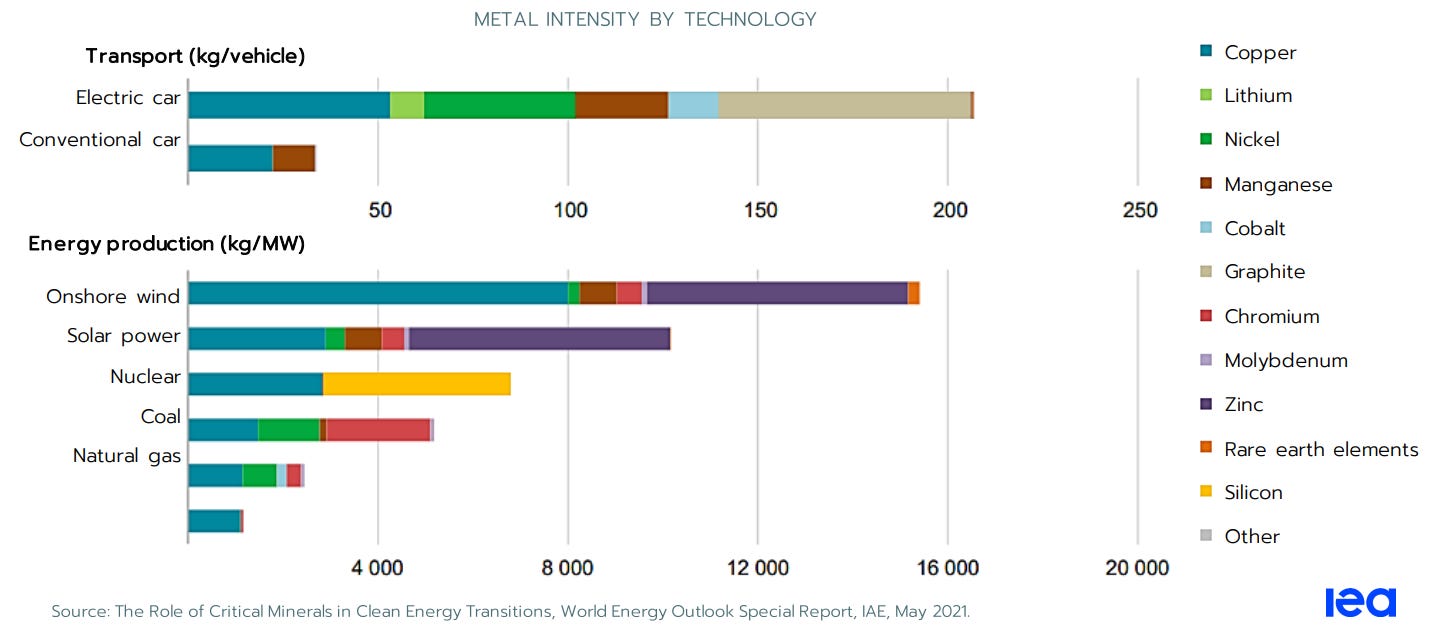

L’altra cosa che, palesemente, serve sono i materiali. Fabbriche e stabilimenti sono fisicamente imponenti, sono migliaia di tonnellate di svariati materiali a formare il fabbisogno di un’attività che si sovrappone alla transizione energetica, altra voce che richiama un’impennata di bisogni di metalli dalle proprietà più varie:

La domanda di materiali è stimata, in aggregato, quadruplicare nei prossimi due decenni, mentre l’estrazione dei materiali è in rallentamento.

Il rame, ad esempio, è il metallo più monitorato e mentre procede l’esaurimento progressivo delle miniere, gli operatori del settore investono in M&A, formando un classico oligopolio ristretto in una nicchia su cui la domanda è destinata ad esplodere:

L’ambito in cui è possibile concentrarsi è quindi ampio: seguire i destini dell’AI e della sua possibile spinta di produttività, ci fa passare da chi crea le soluzioni software ai produttori di chip e da lì a scendere al settore infrastrutture, e infine ai materiali, dove la gemmazione procede: ci sono gli intermediari di materiali, ci sono le aziende minerarie, e ci sono i prezzi dei materiali.

Come orientarsi in questa selva? Ne parleremo in una prossima newsletter, visto che questa è già sufficientemente lunga :-)